人工知能が引き起こす事故等の法的責任を開発者や活用者が過度に負わされる恐れがあり、技術開発の萎縮や活用の遅れが生じてしまう。

人工知能が引き起こす事故等の法的責任を開発者や活用者が過度に負わされる恐れがあり、技術開発の萎縮や活用の遅れが生じてしまう。

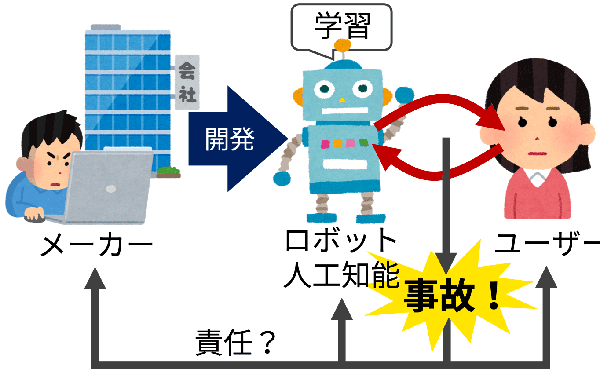

ロボット/AIと人の相互作用の結果生じた事故はそのメーカーやユーザーの責任になるのか?

背景

2010年代初頭からのディープラーニングの発展により、人工知能技術の急速な発展と社会への活用が期待されてきた一方で、社会にもたらす負の影響についても様々な問題提起がなされてきた。

特に法的責任をめぐる論点に目を向けると、人工知能の社会的影響が想定されていない現在の法制度においては、自律的に学習する人工知能が引き起こした事故等の法的責任を開発者や人工知能の活用者に過度に負わせる恐れがあり、このような過度な責任帰属を恐れて技術開発自体が萎縮してしまう、または活用が進まないといった問題が生じうることが指摘されている。

研究開発のアプローチ

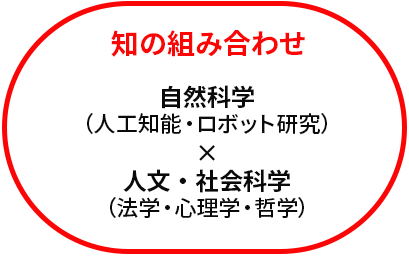

これらの問題に対応するために、本取組では、自律的に学習する人工知能の開発・利用を念頭に現在の法制度を見直し、人工知能と人間の調和に向けて必要な賠償制度・処罰制度のあり方も含めた新たな法制度を考案するための、自然科学者(人工知能・ロボット研究)と人文・社会科学者(法学・心理学・哲学)の協働による研究開発を実施した。

成果

「人間が自由意志を持って外的環境の影響を受けずに客体をコントロールできること」が前提とされている現在の法制度の限界について、現代哲学や法学等の知見を交えて議論を行った。この議論では、継続的に発展していく人工知能を完全にコントロールすることの困難さや、常に外的環境の影響を受けている人間は外界から独立した確固たる自由意志を持ちえない可能性などを踏まえ、「危険が生じた場合は、その危険源をコントロールして、結果を回避できた人間が責任をとるべきである」という、既存の責任法の前提が揺らいでいることを指摘するとともに、新たな法制度の必要性を提言した。

新たな法制度の具体化を検討するために、人工知能研究者や各法制度の専門家が密に連携をとりながら議論を行った。その結果、自律的に学習し確率的・統計的に挙動する人工知能の危険性を適切に処理するためには、①発生した事象のみを理由として、事後的に個人に民刑事責任の帰属を検討する現在の法制度では対応できないこと、そこで、②開発したプロダクトや開発体制の改善を通じて、人工知能システム自体を通時的に発展させるように、関係者にインセンティブできる責任制度を再設計することで、技術の進歩とリスク管理を両立させるという新たな解決策を見出した。

このような人工知能の特性を踏まえた新たな法制度についての議論の内容は、経済産業省の報告書「GOVERNANCE INNOVATION:Society5.0の実現に向けた法とアーキテクチャのリ・デザイン」(2020年7月公表)に反映されるなど、政策への展開も図られた。

|

|

>「人と情報のエコシステム」研究開発領域※ ※本領域における研究開発予算規模(直接経費):1プロジェクト 数百万円から1千万円程度(上限目安2千万円)/年 ※本事例は2017年10月~2021年3月の期間中に実施した複数のプロジェクトの連携による取組例 |