- JST トップ

- /

- 戦略的創造研究推進事業

- /

ERATO

ERATO- /

- 研究領域の紹介/

- 終了領域/

- 石黒共生ヒューマンロボットインタラクションプロジェクト

石黒共生ヒューマンロボットインタラクションプロジェクト

研究総括 石黒 浩

(大阪大学 大学院基礎工学研究科 教授/

(株)国際電気通信基礎技術研究所 石黒浩特別研究所 客員所長(ATRフェロー))

研究期間:2014年7月~2020年3月

特別重点期間:2020年4月~2021年3月

グラント番号:JPMJER1401

ロボットの研究分野の広がりとともに、ロボット研究は、日常的な場面で働くロボットに焦点を移しつつあります。日常的な場面において、人間が最も容易にコミュニケーションを取ることができるのは人間そのものです。そのため、多様な感覚や言語、身体動作を用いて、複数の人間と関わることができるロボットの研究開発が重要になります。

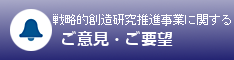

本研究領域では、身振り手振り、表情、視線、触れ合いなど、人間のように多様な情報伝達手段を用いて対話できる、社会性を持つ自律型ロボットの実現を目標に、共生ヒューマンロボットインタラクション(人間とロボットの相互作用)の研究開発に取り組みます。特に、人と安全に関わることができるロボットの皮膚や内部メカニズム、頑健で柔軟な音声認識技術の開発と、欲求、意図、行動・発話の階層モデルの構築を行います。これらにより、特定の状況と目的において自律的に対話できる機能や、複数の情報伝達手段を用いて社会的状況で複数の人間と対話できる機能を開発し、実社会において人間と親和的に関わり、人間と共生するための自律型ロボットの実現を目指します。

開発したロボットの人間らしさは、遠隔操作されるロボットとの比較や、人間との直接的な比較によって評価し、特定の状況、目的、対象者において、ロボットが人と同レベルのものに感じられることを確認します(マルチモーダルチューリングテスト)。さらに、技術の実用化に向けて、ロボットを用いた高齢者や発達障害者の生活支援に取り組みます。具体的には、高齢者介護において物理的支援と同様に重要な対話支援や、発達障害者の療育を目指すとともに、健常者へのコミュニケーション教育・学習支援や公共施設での情報提供や対話サービスへの展開を図ります。

一方、このようなロボットは、人間を理解するテストベッドにもなります。現実的な場面でのロボットと人間との関わりを通して、自己・他者認識、意識、心といった、認知科学や脳科学における重要課題について、理解を深めることが期待されます。

1. 研究成果の概要

ロボット研究はその応用範囲の広がりとともに、日常的な場面で働くロボットに研究の焦点を移しつつあります。人間は人間と日常的にコミュニケーションを行うため、人間同士の対話と同様の手段を用いてコミュニケーションが行える人間型ロボットの研究開発が重要になってきています。このような背景のもと、本研究領域では、身振り手振り、表情、視線、触れ合いなど、人間のように多様な情報伝達手段 (モダリティ) を用いて対話し、実社会において人間と親和的に関わり、人間と共生するための自律型ロボットの実現を目標として、共生ヒューマンロボットインタラクション(人間とロボットの相互作用)の研究開発に取り組んできました。

開発したロボットの人間らしさを、遠隔操作ロボットや人間との対話との比較することで,多数のモダリティを利用した対話の性能を評価しました(マルチモーダルチューリングテスト)。さらに技術の実用化に向けて、生活支援や療育などのロボットを用いた情報提供や対話サービスへ展開しています。

2. 研究成果

本プロジェクトの主要な成果としては, i) 自然な存在感を持つアンドロイドを実現するためのマルチモーダル対話制御システム, ii) 複数ロボットによって対話感を演出する社会的対話ロボット, そして,iii) 対話ロボットの活躍する場面を大きく拡大することを目的にした移動機構を持つ子ども型アンドロイド 「ibuki」 の開発が挙げられます.これらの詳細を以下に示します.

2.1 自律型ロボット研究グループ(大阪大学)

本グループでは、人の生活空間で活動できるロボットのハードウェア開発と人の生活空間の中で頑健に対話を継続できる対話システムに関する研究、実フィールドでサービス提供するアンドロイドの開発に取り組みました。

ハードウェア開発に関しては、人間の生活空間で対話システムを実証的に研究するため、 多様な視線表現の自由度を持つ、卓上型・人間型ロボットCommU (コミュー) を開発しました。さらに電動ながらもバックドライバビリティを持つ減速機を用いることで物理的相互作用を伴うコミュニケーションができ、偏心した車輪と直動機構を組み合わせた移動機構により、人間の歩行時に生じる躍動感を模擬しながら、8時間程度の移動ができる世界初のアンドロイドである、子供型アンドロイド ibuki (図1)を開発しました。

図3: 子ども型アンドロイド ibuki

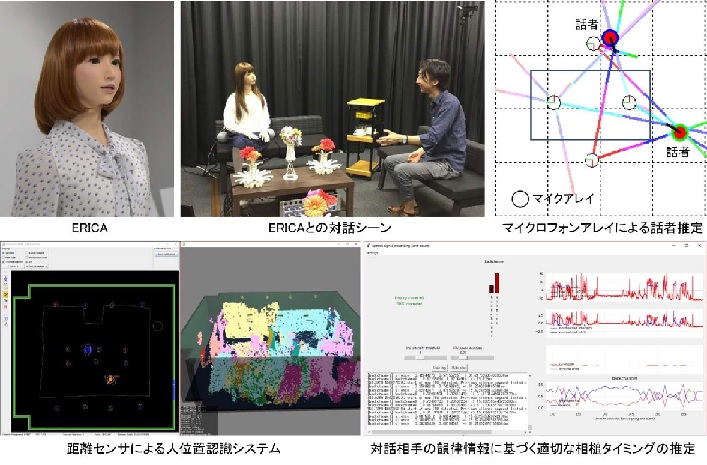

対話システムに関しては、複数体のコミューを連携させることで、人に高い対話感を与えるマルチロボット対話制御システムを開発しました(図2)。また提示した候補文を選択させることで、高い対話感を得ながらロボットと対話できるタッチパネル対話インタフェースを開発しました。さらに、無限関連性モデルに基づく推論過程を人に提示しながら、人の好みを話題として、高い対話感を与える選好推定対話システムを開発しました。

図2: 複数台のCommU を用いた対話の破綻を感じにくい対話システム

そして多様な業種の企業と協働し、商業施設やレストランでの接客、高齢者との対話支援、英語の学習支援、ロボットとの対話を通した療育など、様々な側面から人の生活空間の中で実証実験を行い、開発した対話システムや対話ロボットの有用性を明らかにしました。

今後の研究では、本プロジェクトの成果の対話システムを、移動機能を持つロボットに統合し、共有した経験を基に人と対話をし続けられるロボットの実現を目指していきます。

- Yusuke Nishimura, Yutaka Nakamura, and Hiroshi Ishiguro, “Human interaction behavior modeling using Generative Adversarial Networks, ” Neural Networks 132, pp.521-531, 2020

- Hirokazu Kumazaki, Yuichiro Yoshikawa, Yuko Yoshimura, Takashi Ikeda, Chiaki Hasegawa, Daisuke N. Saito, Sara Tomiyama, Kyung-min An, Jiro Shimaya, Hiroshi Ishiguro, Yoshio Matsumoto, Yoshio Minabe and Mitsuru Kikuchi, “The impact of robotic intervention on joint attention in children with autism spectrum disorders, ” Molecular Autism, 9:46, 2018

- Takamasa Iio, Ryota Maeda, Kohei Ogawa, Yuichiro Yoshikawa, Hiroshi Ishiguro, Kaori Suzuki, Tomohiro Aoki, Miharu Maesaki, Mika Hama, “Improvement of Japanese adults’ English speaking skills via experiences speaking to a robot,” Journal of Computer Assisted Learning, 2018

- Tsunehiro Arimoto, Yuichiro Yoshikawa and Hiroshi Ishiguro, “Multiple-Robot Conversational Patterns for Concealing Incoherent Responses,” International Journal of Social Robotics, 2018

- 渡辺 美紀, 小川 浩平, 石黒 浩, “ミナミちゃん:販売を通じたアンドロイドの実社会への応用と検証,” 情報処理学会論文誌, Vol.57, No.4, pp.1251-1261, 2016

2.2 音声対話研究グループ(京都大学)

本グループでは、人間型ロボット(アンドロイド)との自然な音声対話を実現するために、頑健な音声認識と柔軟な音声対話に関する研究を行ってきました。また、自律型ロボット研究グループ・実証研究グループと連携して,傾聴や就職面接のタスクを設定して,人と対話するアンドロイドの開発に取り組んできました。

対話ロボットの音声認識では、雑音が多い実環境で、接話マイクを使わずに、自然な話し言葉を扱える必要があります。そのために、雑音抑圧を効果的に統合する方法と音響モデル・発音辞書・言語モデルを統合したAcoustic-to-Wordモデルを開発しました。これにより、従来手法の30倍以上の処理速度(実時間比0.03)で高精度な音声認識を実現しました。また、人間レベルの対話を実現する上で、多様で自然な相槌生成と円滑なターンテイキングが鍵になると考え、これらのモデル化とコーパスに基づく学習を行いました。その結果、高齢者との対話においても発話衝突することなく、相槌により発話を促進できるようになりました。

アンドロイドの対面対話が効果的に機能する場面として、傾聴と就職面接(練習)を行うシステムを開発しました。傾聴システムについては、多数の高齢者との実験を行い、遠隔操作(WOZ)対話との比較評価も行いました。その結果、話しやすさや話を聞いていた印象に関する評定値では、自律アンドロイドとWOZで同レベルでした。ただし、「理解」や「共感」に関する評定では有意な差がありましたので、カウンセリングの専門家と共同で今後の改善の方向を検討しています。

- T.Kawahara. Spoken dialogue system for a human-like conversational robot ERICA. In Proc. International Workshop Spoken Dialogue Systems (IWSDS), (keynote speech), 2018

- K. Inoue, D. Lala, K. Takanashi, and T. Kawahara, Engagement recognition by a latent character model based on multimodal listener behaviors in spoken dialogue, APSIPA Trans. Signal & Information Process., Vol.7, No.e9, pp.1-16

- D.Lala, K.Inoue, and T.Kawahara.Smooth turn-taking by a robot using an online continuous model to generate turn-taking cues.In Proc. ICMI, pp.226-234, 2019.

- K.Inoue, D.Lala, K.Yamamoto, S.Nakamura, K.Takanashi, and T.Kawahara. An attentive listening system with android ERICA: Comparison of autonomous and WOZ interactions. In Proc. SIGdial Meeting Discourse & Dialogue, pp.118-127, 2020.

- 井上昂治, 原康平, ララディベッシュ, 山本賢太, 中村静, 高梨克也, 河原達也. 掘り下げ質問を行う就職面接対話システムの自律型アンドロイドでの実装と評価.人工知能学会論文誌, Vol.35, No.5, pp.D-K43_1-10, 2020.

2.3 実証研究グループ (国際電気通信基礎技術研究所(ATR))

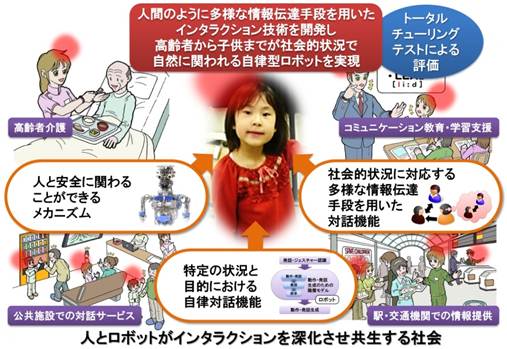

本グループでは、様々なセンサ情報を利用して、対話相手の意図も含めた状況を認識するマルチモーダル認識システムと、視線やジェスチャなどの様々なモダリティを利用して情報を伝えるアンドロイドを組み合わせ、統合したマルチモーダル対話制御システムを開発しました。

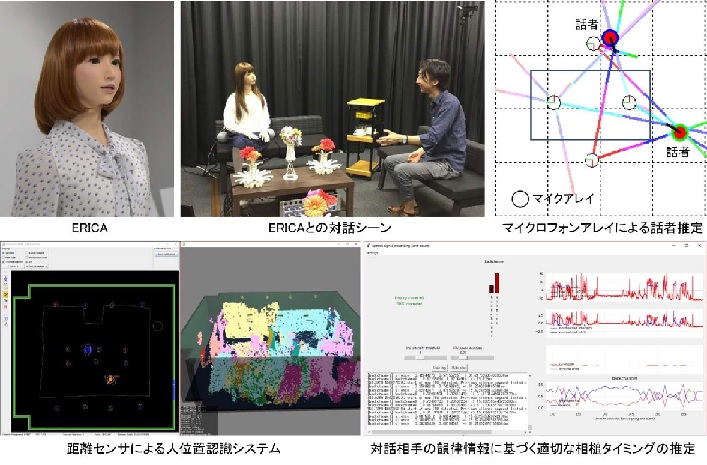

人間に酷似した姿を持つアンドロイドERICAを開発するとともに、発話に同期した自然な口唇動作・頭部うなずき動作・表情・ジェスチャなどのマルチモーダルな動作生成システムの構築、マイクロホンアレイやRGB-Dセンサをなどの多様なセンサ情報を用いた、人位置・顔・表情・音声認識システムの構築、またそれらの状況認識結果に基づく発話衝突や対話エラーに対応する手法、さらに音声対話研究グループで開発された相槌生成手法や発話終了検出手法等を統合し、人間らしく対話するアンドロイドの基礎技術、すなわちマルチモーダル対話制御システムを開発しました(図3)。

また、ロビーに設置したブースに、ERICAが初対面の訪問者と対話するシステムを構築し、常時運用を1年以上継続しながらシステムの更新を行うなどの、実証実験にも取り組みました。開発した対話システムで制御される ERICA と対話した者の中には、人が遠隔操作していると思う者も少なからず現れています。

今後は、アンドロイドERICAのマルチモーダルチューリングテストに本格的に取り組むとともに、 初対面以外での状況でも、自然な対話ができるようにシステムを拡張していきます。

図3: アンドロイド ERICAのマルチモーダル対話制御システム

- Changzeng Fu, Chaoran Liu, Carlos Toshinori Ishi, Hiroshi Ishiguro, “Multi-modality Emotion Recognition Model with GAT-based Multi-head Inter-modality Attention,” Sensors 20(4894), pp.1-15, 2020

- 内田貴久, 港隆史, 石黒浩, “対話アンドロイドに対する主観的意見の帰属と対話意欲の関係, ” 人工知能学会論文誌, 34(1), B162_1-8, 2019

- 石黒 浩, 港 隆史, 小山 虎, “意図欲求を持つ自律対話アンドロイドの研究開発,” 日本ロボット学会誌, Vol.37, No.4, pp.312-317, 2019

- Carlos T. Ishi, Daichi Machiyashiki, Ryusuke Mikata, Hiroshi Ishiguro, “A Speech-driven Hand Gesture Generation Method and Evaluation in Android Robots,” IEEE Robotics and Automation Letters, 2018

- Kurima Sakai, Takashi Minato, Carlos T. Ishi, Hiroshi Ishiguro, “Novel Speech Motion Generation by Modelling Dynamics of Human Speech Production,” frontiers in Robotics and AI, 2017

参考ビデオ

- ・ https://www.youtube.com/watch?v=j1h1KOeCHjg

- ・ https://www.youtube.com/channel/UCDjRgo5ecEw0Ou78-uJOssg

- ・ https://www.youtube.com/channel/UCY7OAwFBg-xmhlJZp_2PQGw