研究への情熱映像と取材記事

大自由度ニューラルネットワークの学習に潜む幾何学的構造の解析と信頼性評価への展開

- 人工知能

- 数理科学

- 情報学

唐木田 亮

(産業技術総合研究所 人工知能研究センター 主任研究員)

人工知能(AI)の中でも、近年、大きな力を発揮するようになった「ニューラルネットワーク」。「なぜ正解が導き出せるかはブラックボックス」といわれることも多いが、最近では、その仕組みを数理的に理解しようという研究が世界中で進んでいる。唐木田さんはそうした研究者の一人として、高い性能を示すニューラルネットワークや問題となる現象の背景を明らかにしたいと考えている。その先にあるのは、新たなニューラルネットワークモデルとその学習法の開発だ。

学習過程の数理的理解が

これからのニューラルネットワーク発展の鍵

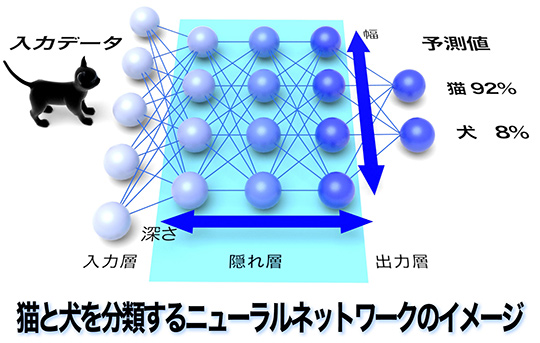

ニューラルネットワークとは、人間の脳神経回路を模した階層性の機械学習モデルの一つだ。入力層、隠れ層、出力層のニューロンがそれぞれ結合しており、隠れ層の深さ(層の数)と幅(各層のニューロン数)は学習内容に合わせて様々に設計される。学習後に入力層にデータを与えると、隠れ層での計算(重みづけや変換など)を経て、出力層では分類や予測などの解答が得られる。すでに1960年代には、ニューラルネットワークを使って、入力データを与えれば望ましい出力が得られるようなシステムをつくろうとする試みが始まっていた。なかなか性能が上がらなかったが、2010年代に入ると、画像識別や音声認識の分野でほかの機械学習法に比べてはるかに高い性能を示すようになった。今では「柔軟に情報を処理するシステム」として定着している。

唐木田さんは、ニューラルネットワークが発展した背景を「大量の学習用データが準備できるようになり、大量のパラメータ(変数)をもつニューラルネットワークモデルが次々に提案されたことに加え、それらを扱える充実した計算機環境が登場したからです」と説明する。産業技術総合研究所にも、世界最大規模の人工知能処理向け計算インフラストラクチャ「ABCI(AI Bridging Cloud Infrastructure)」がある。

高い性能のニューラルネットワークを実現するには、おもにモデル構造と学習方法が重要な役割を担っており、唐木田さんは特に「学習」のさせ方に注目している。ニューラルネットワークモデルの学習にはいくつか種類があるが、いずれも与えられたデータに対してある種の正解を導き出せるように、モデルのもつパラメータを最適化する。「次々に新しい学習の枠組みが登場していますが、多くは発見的(経験的)な手法で、どのように正解が導かれるのかは説明されません。そこを数理的に理解して裏づけを与えながら制御できるようにしたいのです」。

唐木田さんの研究の一つは「継続学習」だ。継続学習では、例えば、猫を識別できるように学習させたニューラルネットワークを、さらに車を識別できるように継続的に学習させる。すると、両方の識別が可能になるという期待に反し、現実には最初に学習した猫の識別はできなくなってしまう。これを「破滅的忘却(catastrophic forgetting)」といい、ニューラルネットワークの負の側面として回避方法が模索されている。

「たとえば、メモリー容量に限りのあるスマホなどに搭載するには、一つのニューラルネットワークで複数のタスクをこなす継続学習が重要になります。そこで、破滅的忘却はどのようなモデルでも起こるのかを明らかにしたいと考えました」。唐木田さんは、問題の検証に「可解モデル」を用いた。可解モデルとは、解けるように単純化あるいは抽象化されたモデルのこと。今回は、大量のパラメータの影響を見るために、隠れ層の幅が広い極限をとった「大自由度ニューラルネットワーク」を対象とした。検証の結果、破滅的忘却はこのモデルでも起こり、普遍的な現象である可能性が示唆された。また、破滅的忘却が起こるかどうかには、学習の順序やデータ量が関わることも明らかになった。

「可解モデルを理論解析する中で、これまで機械学習では知られていない法則や原理が見つかり、新しい現象を予言できたらうれしいですね」と唐木田さん。数理と実験の両方の研究を行う中で、実験を説明する数理だけでなく、数理に駆動された新しいモデルや学習法も開発したいと考えている。そのために、学習の高速化をめざした研究にも取り組んでいる。

ニューラルネットワークを数理的に理解しようとする分野には、数学、統計学、計算機科学など様々な分野の専門家が集まる。物理学出身の唐木田さんは、「問題に対して可解モデルを考えるのは、物理学でよくやられることです。また、情報科学の問題に物理学にルーツをもつ計算手法が役立ったケースもありました。違ったバックグラウンドをもつ方たちと、それぞれ異なる道具立てを持ち寄りながら同じ問題に向き合っていることが、分野の発展につながると期待しています」と話す。

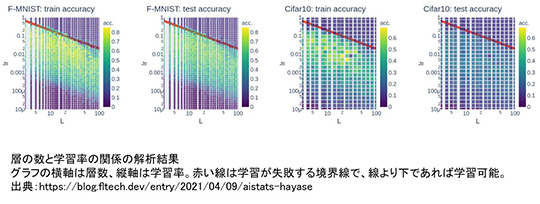

中でも、元ACT-X研究者(現 クラスター株式会社メタバース研究所主任研究員)で数学を専門にする早瀬友裕さんとは、共にいろいろな成果を上げてきた。その一つが、「層の数が多い(層が深い)ほど、性能はよくなるのか」というニューラルネットワークへの根本的な問いに対する研究成果だ。

一般的に、層数を増やせば性能はよくなるが、増やし過ぎると信号が出力まで伝わらないという現象が起こる。この問題を可解モデルで検証した結果、学習率を調整することで解決できそうだという知見が得られた。

唐木田さん、早瀬さんが考えるニューラルネットワークが実装される日は近いのだろうか。「数理的に性質がよいアルゴリズムを見つけたとしても、パラメータが多いために計算コストがとても大きくなり簡単に動かなかったりします。どうしたらモデルを効率的に動かせるかを、計算機科学の人たちと考えなくてはなりません。また、破滅的忘却など、現在のニューラルネットワークにはまだ脳に学ぶ部分があってもおかしくはないと感じており、神経科学や理論神経科学の人たちとも密な関係を築きたいです」と唐木田さんはいう。

ニューラルネットワークの数理は、今、理論的にも実験的にも明らかになりつつある。今後の展開のために、さらに多くの分野を巻き込んだ連携が始まろうとしている。

*取材した研究者の所属・役職の表記は取材当時のものです。

研究者インタビュー

研究について

この研究は、ACT-X研究領域「数理・情報のフロンティア(河原林健一 研究総括)」の一環として進められています。また、ACT-Xの詳細はこちらをご参照ください。